カメラデバイスが軽量、安価になることに伴い、実世界で自分の頭部などに装着したビデオカメラから得られる1人称のビデオ信号の収集と利用への期待が高まっている。

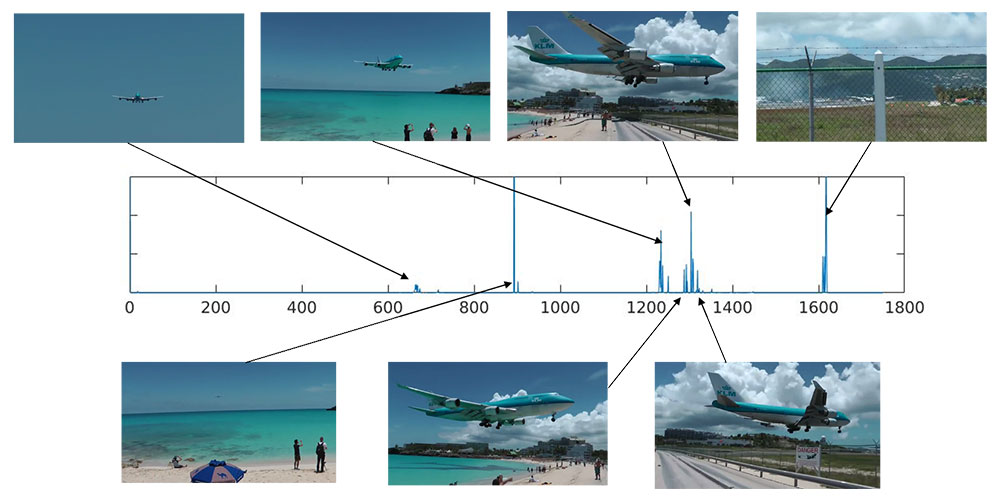

しかし、日常生活の中で撮られた1人称ビデオの信号は冗長であり、不要なシーンが多く含まれているため、重要な情報を含むキーフレームの抽出へのニーズが高い。

しかし、1人称ビデオは、身体の動きに伴う画面の揺れや、不規則なシーン変化などが多く、安定したキーフレームの抽出が難しいという課題がある。

そこで、ビデオ情報と身体運動の情報を共通の特徴空間に射影することで統合した後にキーフレームを抽出する新しい手法を提案した。

2つの手法について、MATLAB と Python のソースコードを公開

スパースコーディングによるキーフレーム抽出

https://github.com/aistairc/SC_based_keyframe_extraction

スパースコーディングと複数センサ統合によるキーフレーム抽出https://github.com/aistairc/SC_MS_based_keyframe_extraction

手法の詳細の論文

Yujie Li , Atsunori Kanemura, Hideki Asoh, Taiki Miyanishi, Motoaki

Kawanabe, "Extracting key frames from first-person videos in the common space of multiple sensors",

Proceedings of 2017 IEEE International Conference on Image Processing (ICIP), 2017 DOI:

10.1109/ICIP.2017.8297032

| 研究開発プロジェクト | NEDO 次世代人工知能・ロボット中核技術開発の成果 |

| 研究機関 | 国立研究開発法人 産業技術総合研究所 |

| 主要研究者 | Yujie Li(産業技術総合研究所、現 桂林電子科技大) |